Es war mal an der Zeit aus der Workstation mit Nested Nutanix CE 1 bzw. 3 Node Cluster mal was neues anzugehen.

Herausforderung:

- 3 mal Intel Skull Canyon mit 32GB RAM und Core i7 CPU

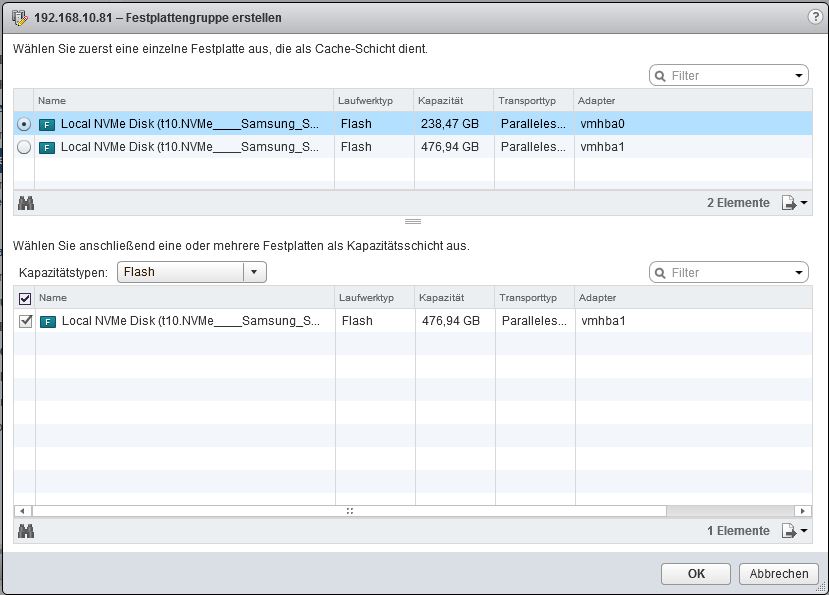

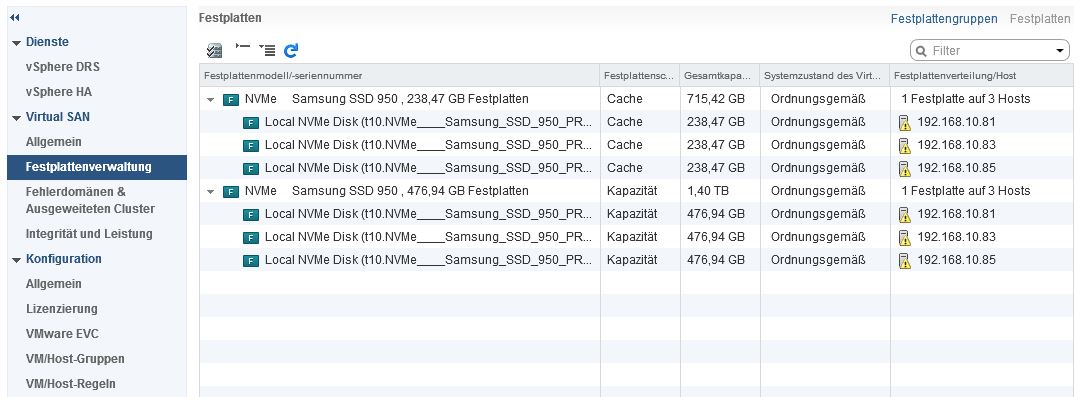

- 6 mal SSDs mit NVMe Adapter

- Skull hat nur 1 NIC onboard mit 1Gbit/s

- VMware VCSA Appliance sollte als vCenter getestet werden

- VMware VSAN 6.2 auf NVMe Flash. Nutanix CE Edition unterstützt das erst kurzfristig in einem neuen Release.

Soweit die Theorie!

Aufbau und Betrieb sind grundsätzlich mit ESXi 6 einfach. ABER! Wir wollen ja VSAN mit ALL Flach machen!

Daher ein paar Vorüberlegungen:

- 256 GB SSD für Cache Storage

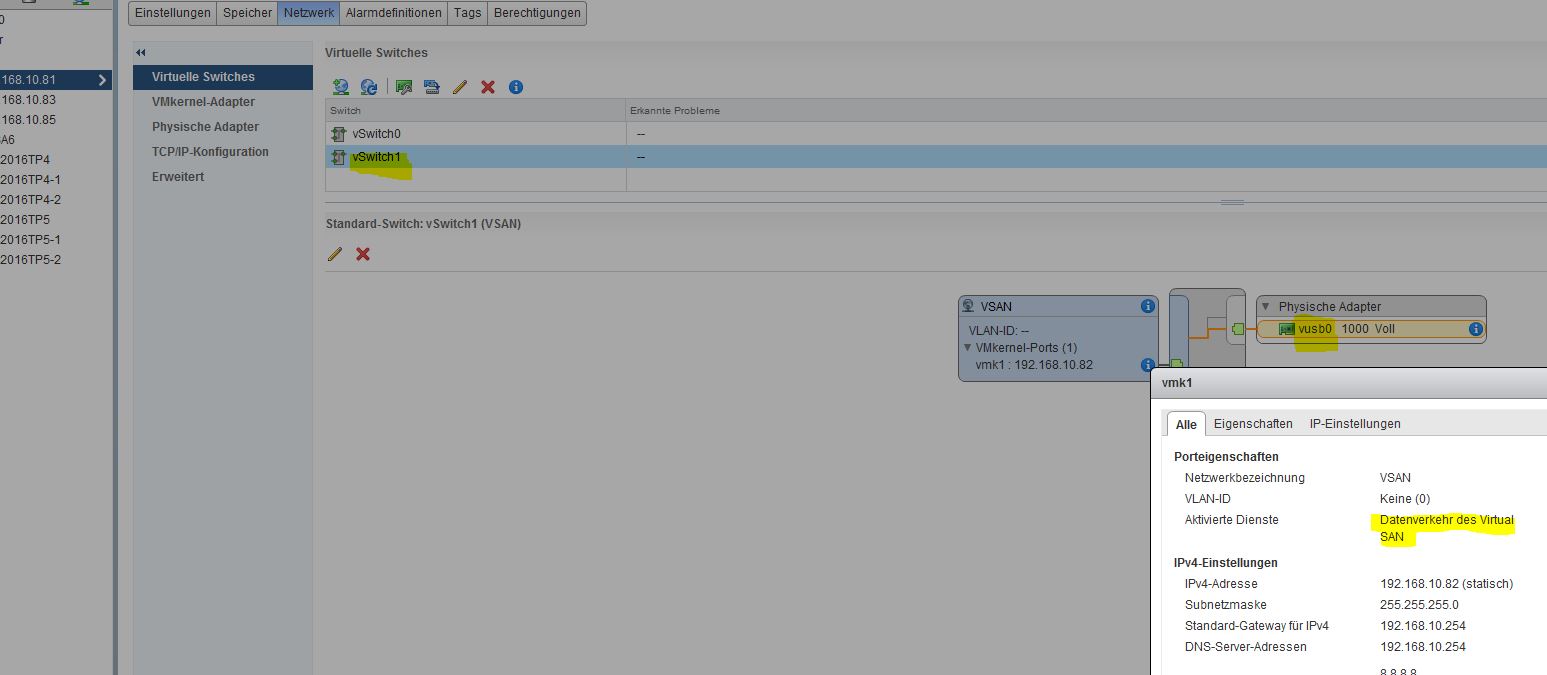

- 512 GB SSD für Data Storage

- für ESXi benötigen wir also zusätzlich mind 8 GB USB Stick zum installieren

- für VSAN wird bei 1 Gbit/s 2ter NIC benötigt! Wir besorgen also USB/Gigabit Adapter mit passenden ESXi Treibern

- SSD dürfen nicht pationiert oder mal mit ESXi installiert sein! Mit Linux Live-Cd dann mal alles vorher löschen!

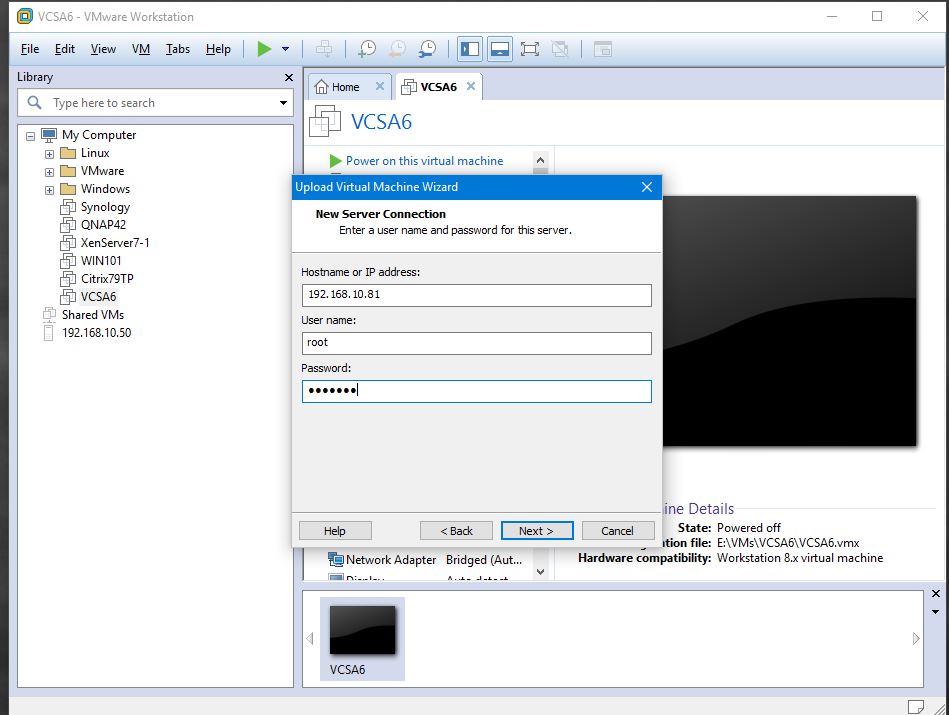

- VCSA zum einrichten wird im ersten Zug dann erstmal auf VMware Workstation parallel daneben gehostet! (Durch den AllFlash Ansatz ist auf den 3 NUCs vor VSAN kein Storage verfügbar für die VCSA)

Durchführung:

- Alle 3 Skulls mit akutell Bios updaten um NVMe Support zu erhalten. Download vom BIOS hier.

- Thunderbold Adapter als Minimum im BIOS deaktivieren zur ESXi Installation! Kann später wieder aktiviert werden

- Ich habe weiterhin WLAN, Blauzahn und Audio deaktiviert sowie den Powermodus von ECO auf Full umgestellt

- Quellen u.a.: virtualghetto

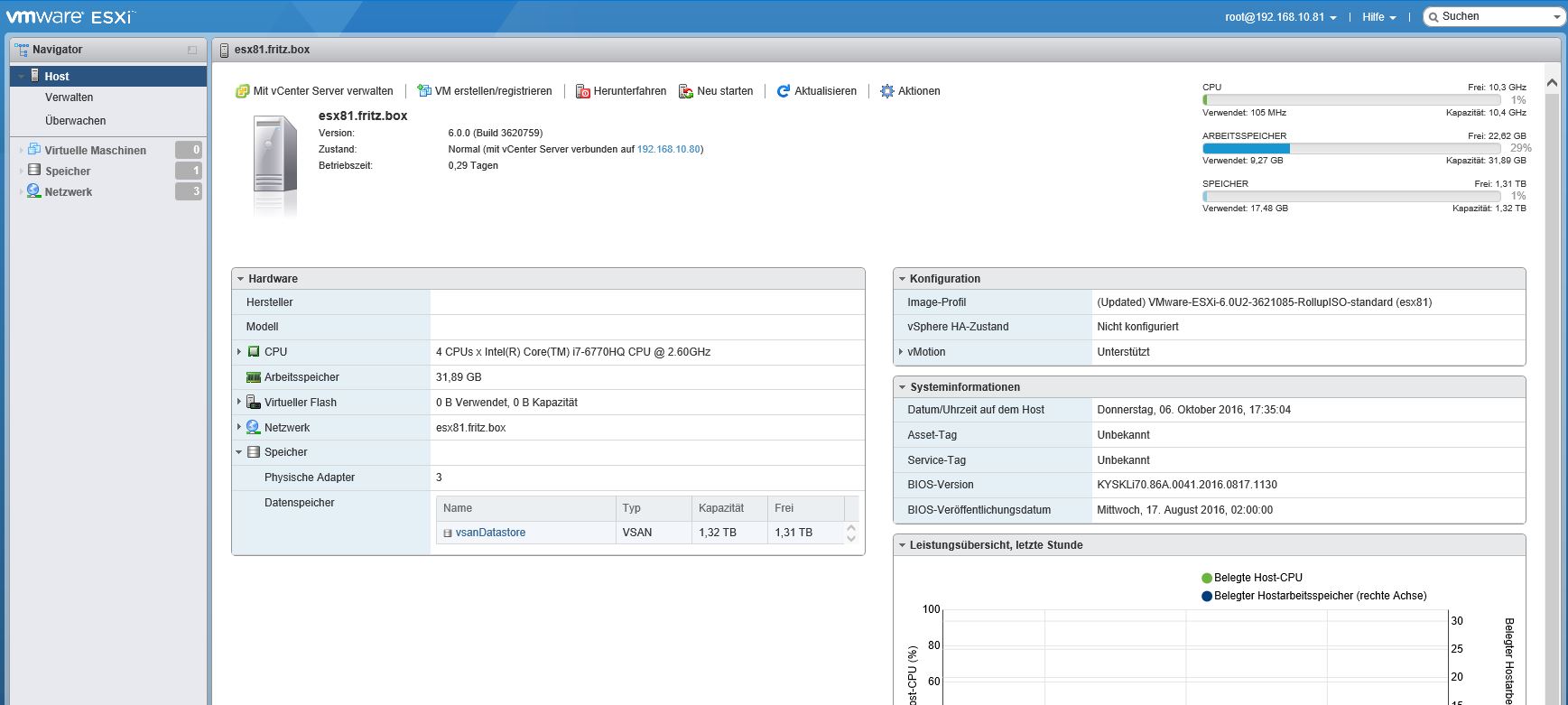

Ergebnis sollte dann 3 mal wie folgt aussehen:

4. Wir modifizieren DNS und IP auf gewünschte STATISCHE Einträge.

5. Wir schalten je Host nun ssh und esxi Shell ein im Sicherheitsprofil der Web GuI

6. Wir kopieren via WinScp oder vergleichbarem Tool den Gerätetreiber (VIB Datei) auf die 3 Hosts

7. Installation der Geräte mit:

a) esxcli network nic list

b) esxcli software vib install -v /pfad/zur/vghet…vib

c) Kontrolle erneut mit esxcli network nic list

8. Anpassung der Policies je Hosts mit SSH

- SSD Monitoring abschalten mit

- esxcli system settings advanced set -o /LSOM/VSANDeviceMonitoring -i 0

- Thick auf Thin Provisioning umschalten mit

- esxcli system settings advanced set -o /VSAN/SwapThickProvisionDisabled -i 1

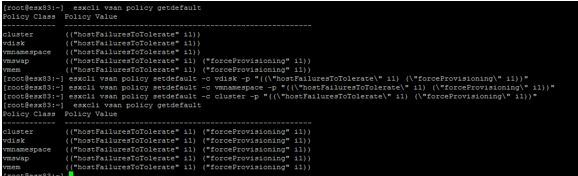

- VSAN Default Policy anpassen 3 mal

- esxcli vsan policy setdefault -c vdisk -p “((\”hostFailuresToTolerate\” i1) (\”forceProvisioning\” i1))”esxcli vsan policy setdefault -c vmnamespace -p “((\”hostFailuresToTolerate\” i1) (\”forceProvisioning\” i1))”esxcli vsan policy setdefault -c cluster -p “((\”hostFailuresToTolerate\” i1) (\”forceProvisioning\” i1))”esxcli vsan policy getdefault

- Sollte dann etwa so aussehen je Host:

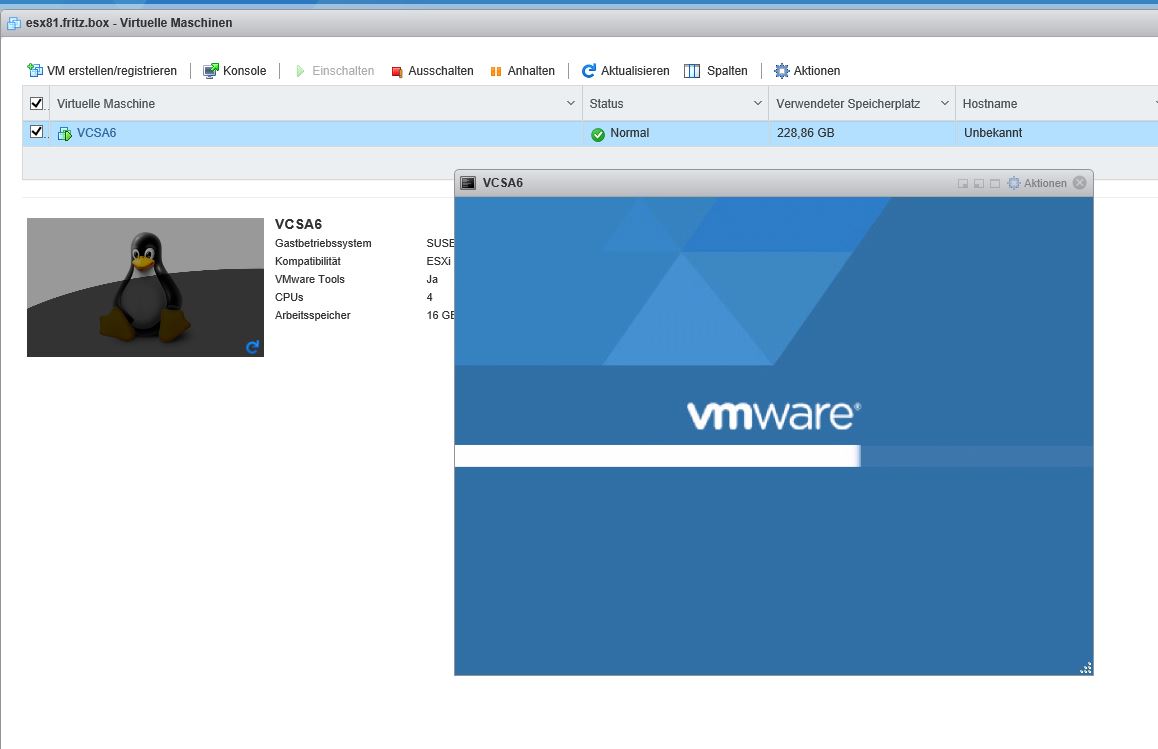

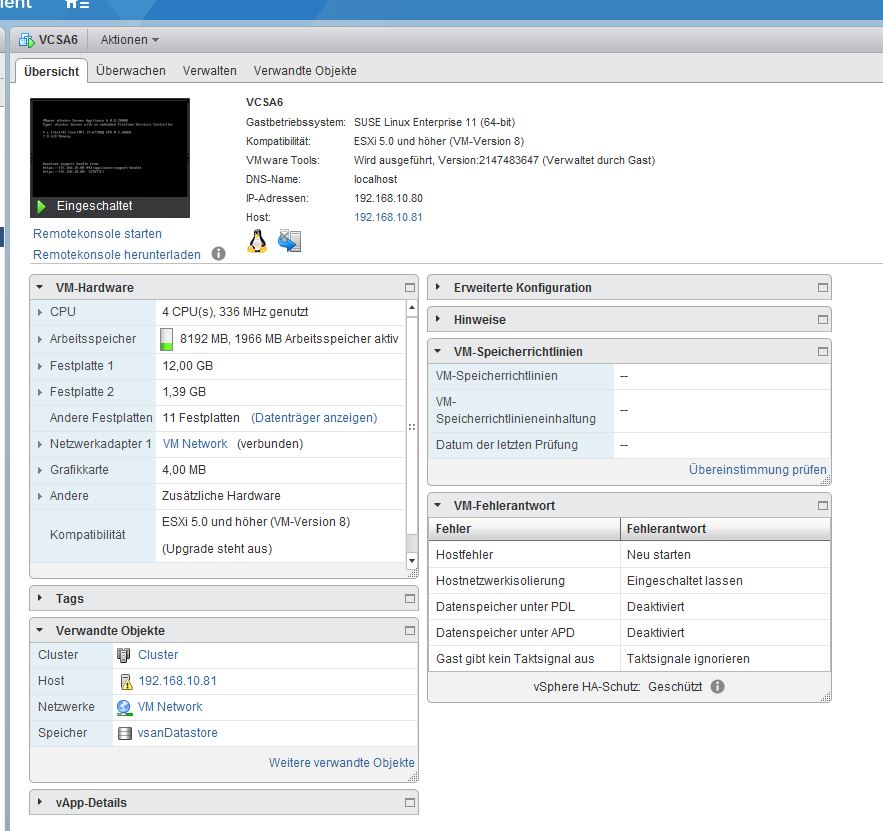

9. VCSA auf VMware Workstation in Betrieb nehmen. Siehe auch.

10. Anschliessend können nun alle Lizenzen für vSpehre, vCenter und vSAN installiert werden.

11. 2ten vSwitch anlegen für die 3 USB-Gigabit Netzwerkkarten. Hier läuft dann nur noch VSAN Traffic drüber!

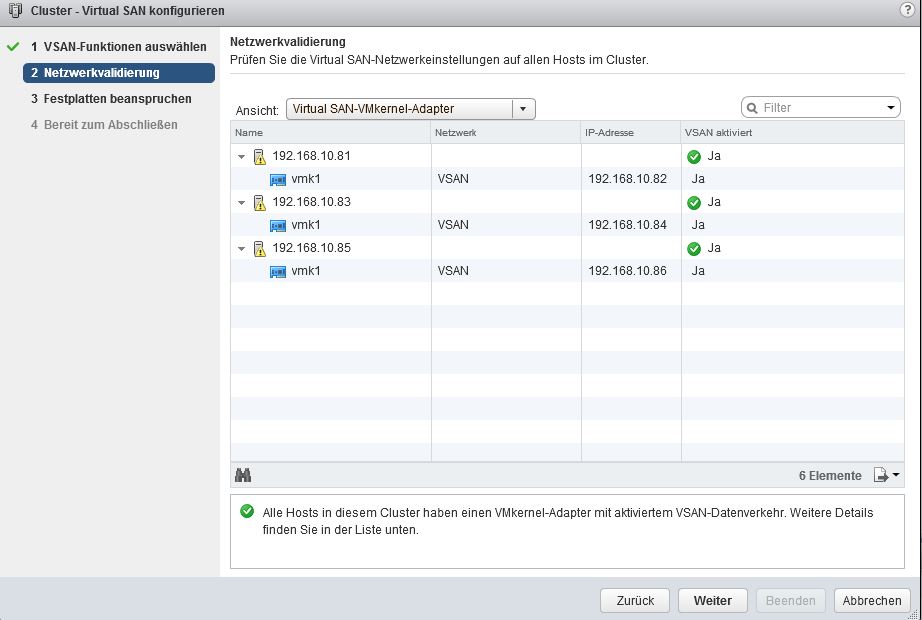

12. VSAN dann einschalten und leere SSDs hinzufügen:

Konfiguration:

13. Kontrolle ob VSAN läuft. ISO Repo anlegen und mal was hochladen.

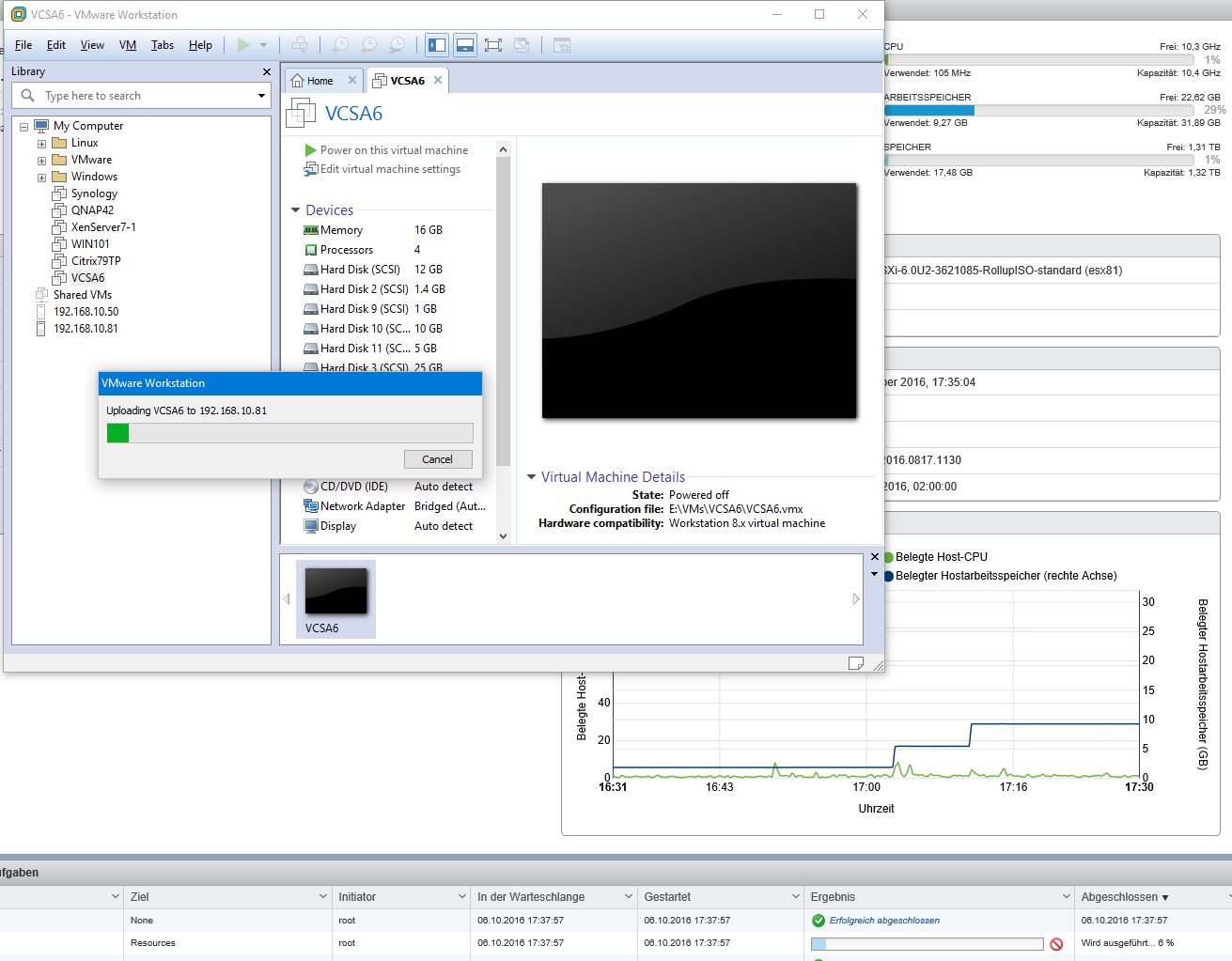

14. VSCA auf Workstation abschalten! und auf einen der 3 ESXi Hosts hochladen

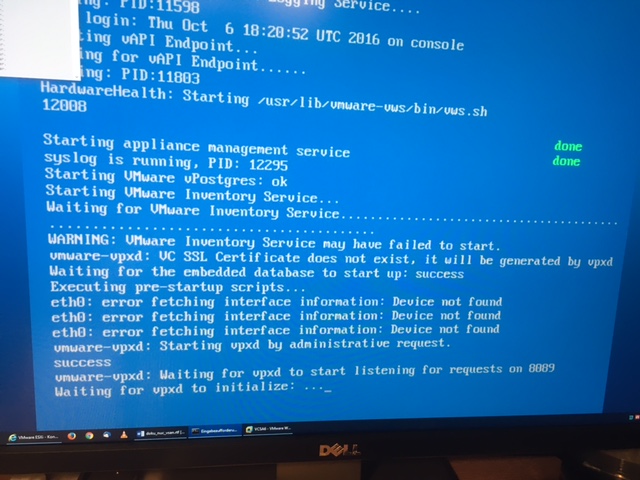

15. ACHTUNG. VCSA hat nun eine neue MAC und damit schlägt nach dem Einschalten einiges fehl da ETH0 fehlt!

Fehlerbild:

Lösung:

DURCHLAUFEN lassen und mit ALT+F1 als lokal an der Appliance anmelden.

Anschliessend die UDEV Regel löschen mit:

vi /etc/udev/rules.d/70-persistent-net.rules

mit dd alles löschen bis auf die oberen Kommentarzeilen.

mit :wq! speichern und REBOOT

Hintergrund: Ursache ist nicht die VCSA Appliance und das Moven. Hier ist es das zugrundeliegende SLES11 OS welches

in den Rules die Alte Netzwerkkaraten MAC festhält und durch den Move NICHT automatisch aktualisiert! Nach dem Reboot

werden die Rules neu geschrieben incl. aktueller MAC und ETH0 und damit die VCSA laufen wie gewünscht.

Folge:

Bingo!

- VCSA auf VSAN Datastorage läuft

- ISOs können zum Installieren nun auch hochgeladen werden

- Dem weiteren Testbetrieb steht nix mehr im Wege.

Alternative: OVF beim Import modifizieren

http://www.virtuallyghetto.com/2013/02/automating-vcsa-network-configurations.html

http://www.virtuallyghetto.com/2012/02/ruby-vsphere-console-rvc-16-released.html

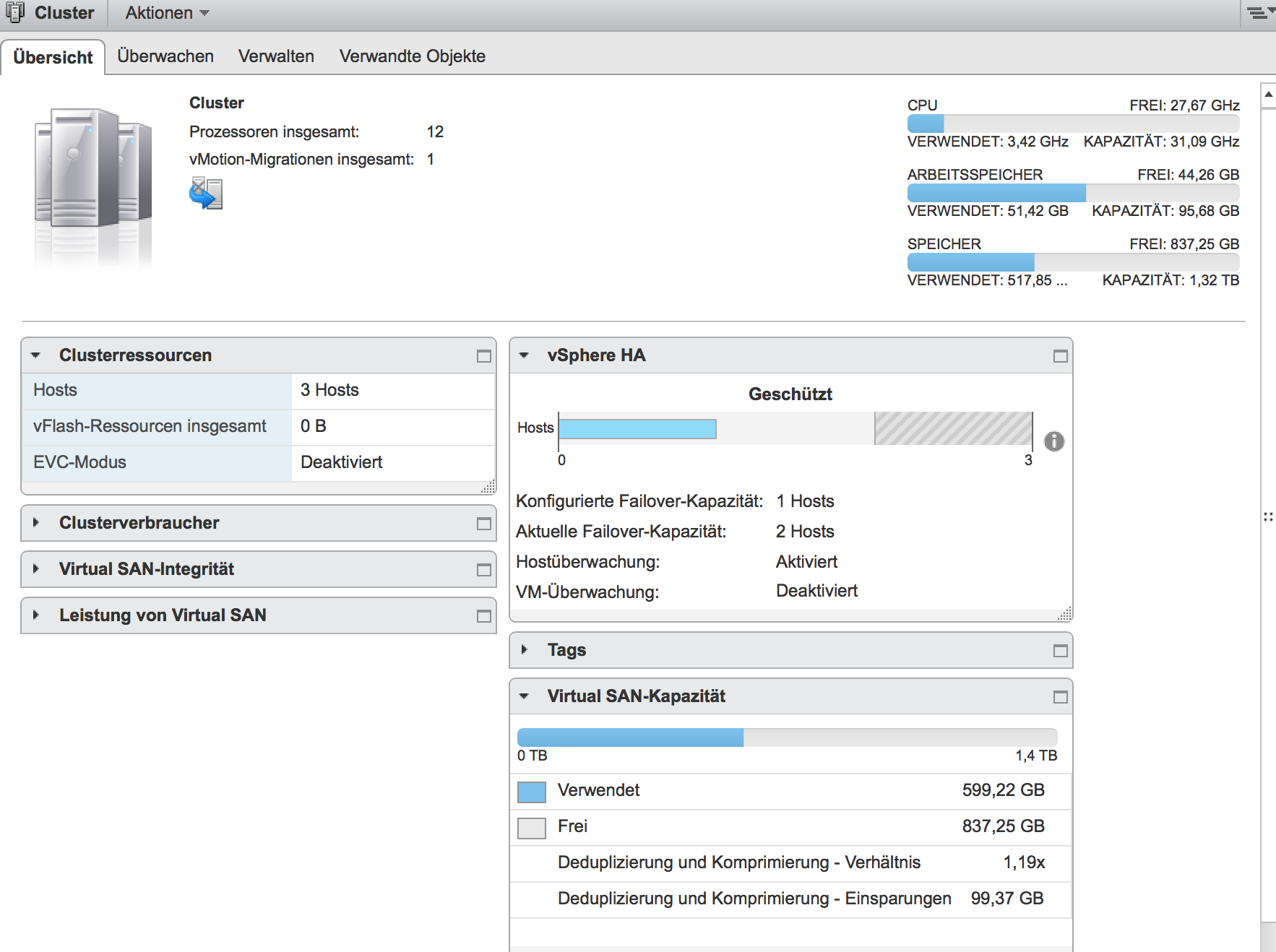

16. FAZIT

Aus

wird

incl. Dedup und Compression auf ALL Flash Hardware! Selbst der mutwillige Boot bzw. das Abschalten eines

Hosts funktioniert. Auch vMotion läuft sauber und SCHNELL.

Das schönste am Schluss:

ACHTUNG: Diese Doku erhebt keinen Anspruch auf Vollständigkeit! Ein Betrieb in Produktions-

umgebungen wird NICHT empfohlen! Weitere Infos und Dokus können untern den

genannten Links, bei VMware und in Youtube nachgesehen werden.