Nachdem ich in Teil 2 den Aufbau eines virtuellen 3 Knoten Clusters mit Nutanix CE erklärt habe, geht es heute an die praktische Einrichtung und den Betrieb.

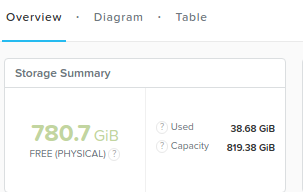

Vorab sollte man sich aber einige Gedanken machen! Wir haben 3 KVM Hypervisoren mit je 16GB RAM in der VMware Workstation laufen. Weiterhin sind in jeder KVM eine CVM von Nutanix mit nun abgespeckten 6 GB RAM am Start. Bleiben also ca. 10 GB je Node zur freien Verfügung. Ebenso haben wir virtuell jedem Node 200 plus 500 GB an SSD Storage mitgegeben. Macht nach RAID 5 Lehre 3×700 / – 700 ca. 1.400 GB an Storage. Ist da so? NEIN. Nutanix braucht selbst je CVM ja auch Storage zum Betrieb! In unserer virtuellen Konstruktion bleiben aber immerhin:

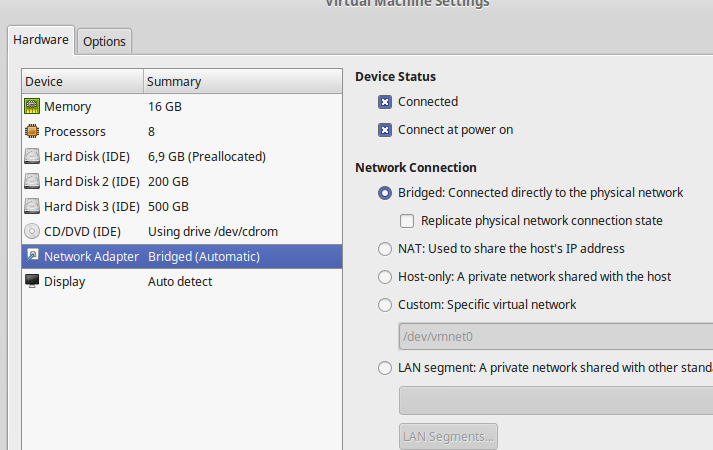

Das Netzwerk ist zu beachten. Hier können wir im Cluster nur auf das zugreifen, was wir in der VMware Workstation eingestellt haben. Ziel war es, auf die VMs in Nutanix von Aussen zugreifen zu können. Mithin sind die Netzwerkkarten in der VMware Workstation alle 3 auf Bridged gestellt.

Damit können wir einen Zugriff aus dem LAN direkt auf die VMs unter Nutanix erstellen. Bleiben aber 3 Nachteile übrig.

- Wir haben keinen dedizierten Storage VLAN Link wie in Produktivumgebungen

- IPMI oder andere Hardware Ports sind virtuell nicht vorhanden

- Der gesamte Traffic läuft über das gleiche Default-VLAN. Virtuelle Perfomance?

Grundeinrichtung für den VM Betrieb:

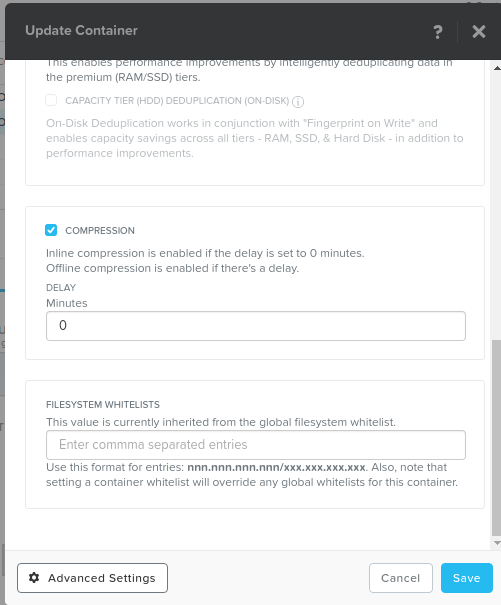

1. Container anlegen für das Speichern von VMs

Die 3 CVMS haben den verfügbaren Storage schon zu einem sog. “Storagepool” zusammengefasst. Aus diesem können wir nun 1 oder mehrere Teile nehmen und für VMs, ISO etc. als sog. “Container” anlegen. Dabei steht immer die maximale Poolgroesse zur Verfügung. Ein Overkommitment wäre ebenso möglich! Sinnvoll ist hier aber zu wählen, ob ein Storagepool z.B. mit oder ohne Compression auskommen soll, oder wir beschränken für die ISO Files den Container auf z.B. 100GB.

Unter Advanced Settings ist jetzt das Feinabstimmen möglich.

Im HomeLab sieht das am Ende dann so aus:

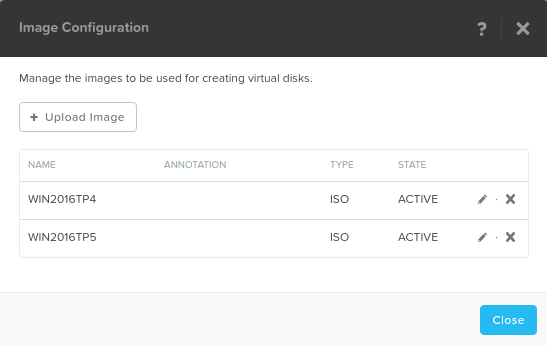

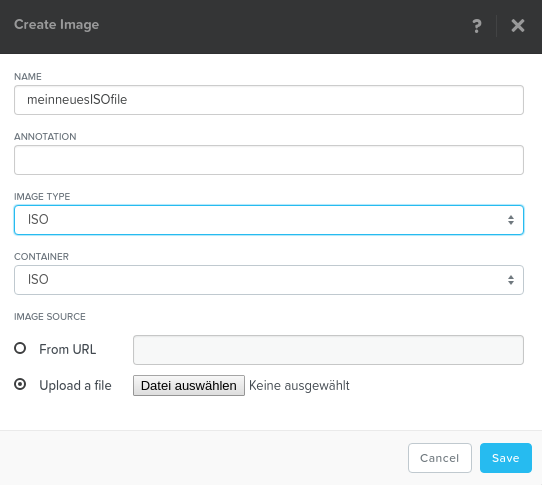

2. ISOs hochladen in die Imageverwaltung

Nutatnix bring im Editierbereich ein eigene ISO Verwaltung mit. Hier kann leicht in den nun erstellten Container “ISO” ein ISO File hochgeladen werden.

Upload Image wählen und los geht es….

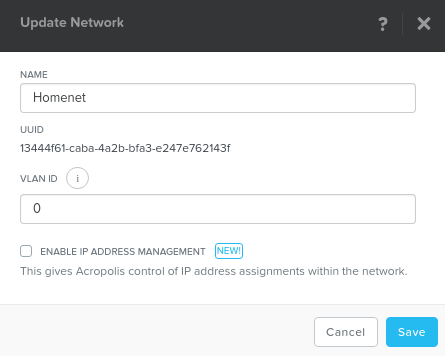

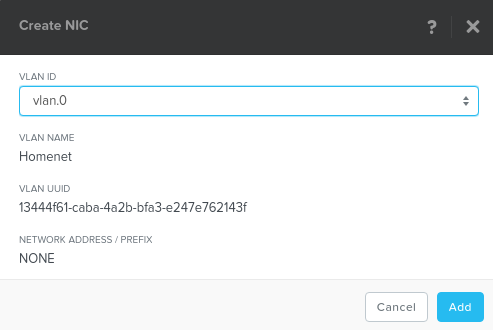

3. Netzwerk für die VMS anlegen

Im Editierbereich muss jetzt der Netzwerkbereich für die VMs angelegt werden. Im HomeLab reicht hier ein Netzwerk mit VLAN ID 0 für alle Netzwerke da wir kein VLAN Tagging durchführen und auch nur 1 Uplink virtuell betreiben.

Die Advanced Settings sind sehenswert, im HomeLab aber eher nachrangig da wir die IPs über einen DHCP von aussen in die virtuelle Umgebung zuführen über das gleiche Netzwerk-Subnetz.

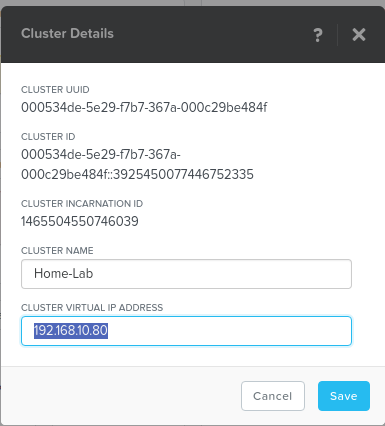

4. Cluster IP MUSS vergeben sein

Kontrolle ob die zentrale Cluster IP eingetragen ist unter Cluster Details:

Hintergrund: Ist die IP nicht eingetragen kann in den VMs später nicht das NGT (Nutanix Guest Tool) mit allen notwendigen Hardwaretreibern installiert werden!

Betriebsmodus:

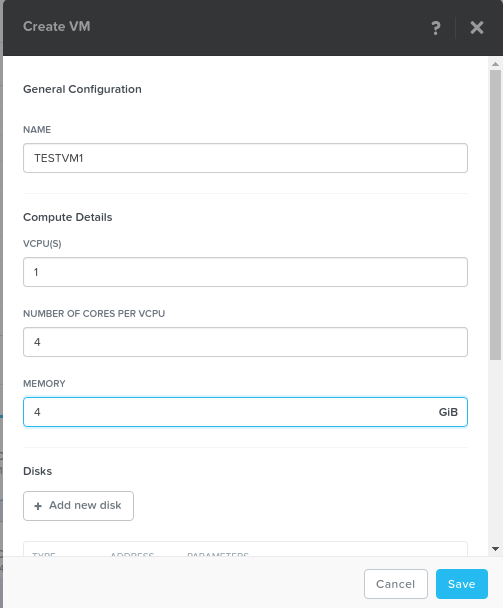

1. VM anlegen

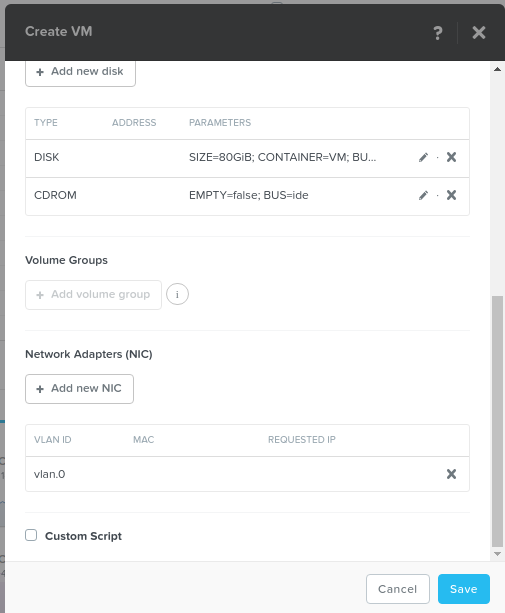

Im Menue VM einfach rechts oben auf CREATE VM und los geht es mit der Auswahl

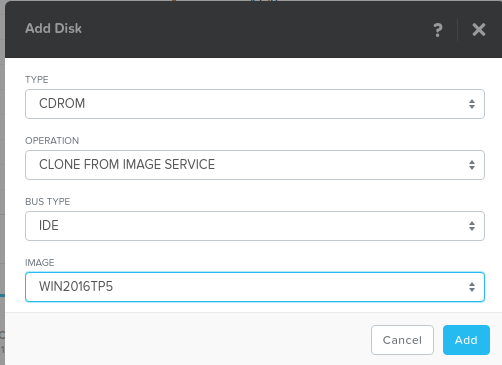

Eine Festplatte unter “Add new Disk” erstellen im Container “VM”

Die Netzwerkkarte nicht vergessen

Zum Installieren dann noch unter DISK dem CD ROM ein ISO File unterschieben oder alternativ das CD ROM löschen und neu anlegen incl. ISO File

ACHTUNG: Die Anzeige zeigt ein leeres CD ROM an, es ist aber ein ISO gemountet.

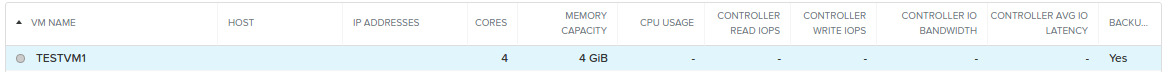

Der Erstellungsvorgang nach Click auf Save dauert nur wenige Augenblicke und die neue VM ist fertig zum einschalten:

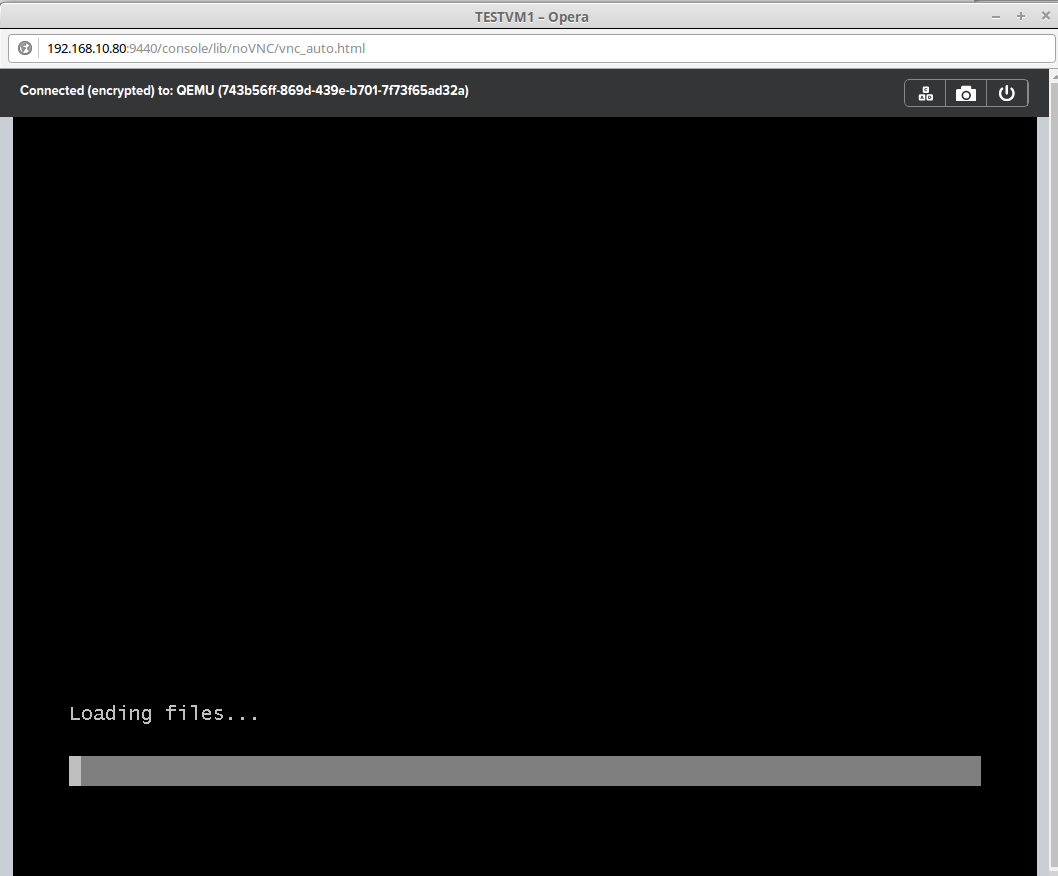

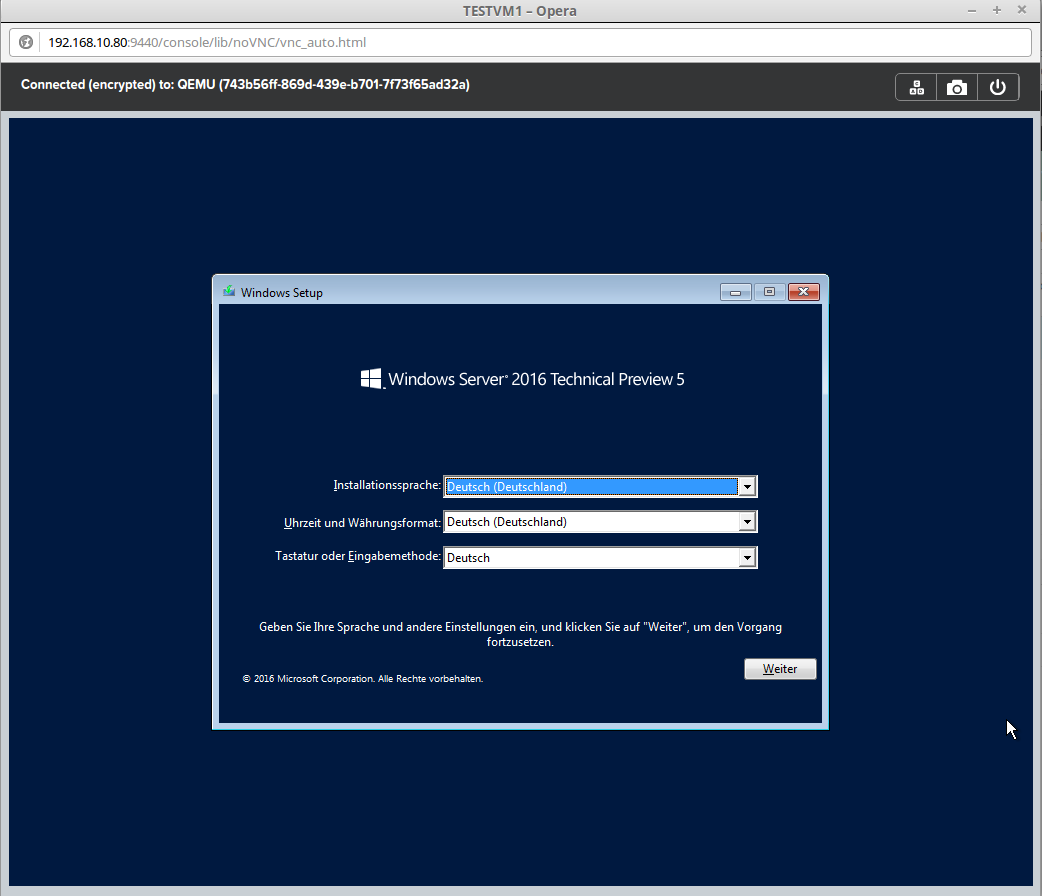

2. VM einschalten und über die Console wie unter VMware / Hyper-V / Xen installieren

![]()

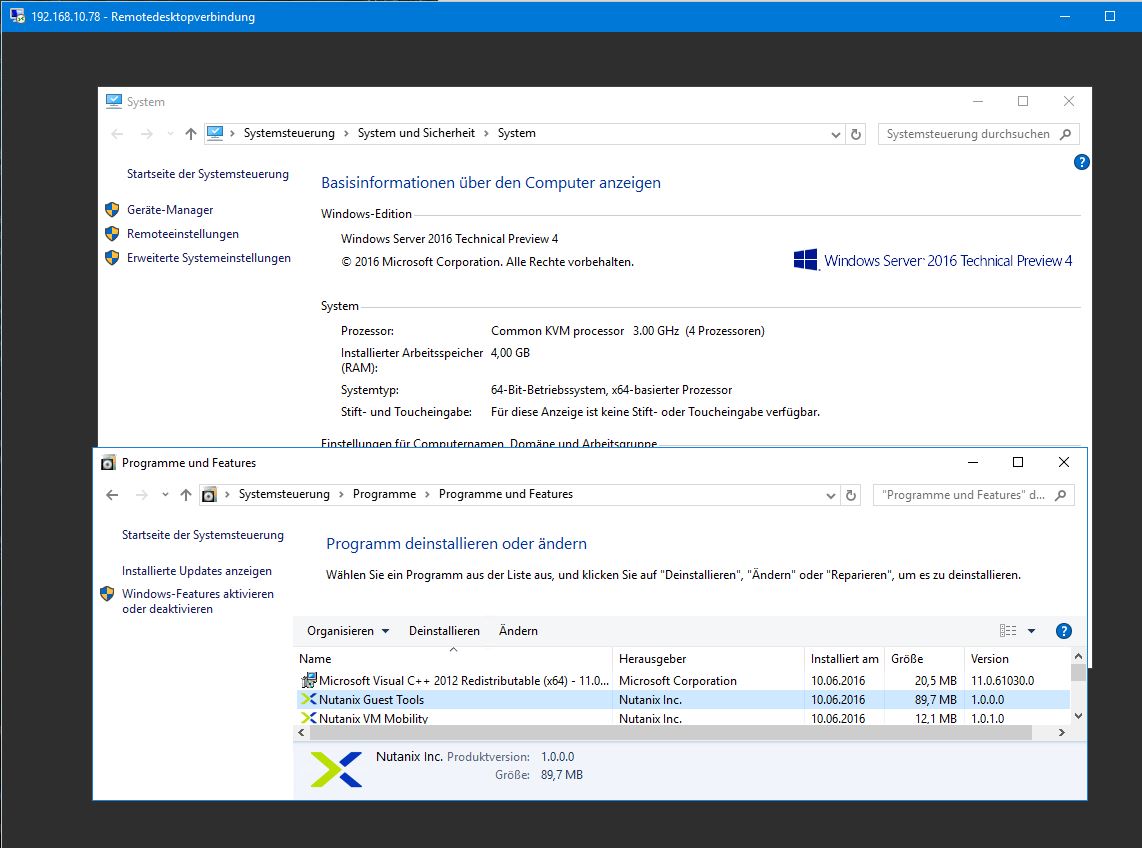

NGT Tools aktivieren in Windows oder Linux VMs! Nach der Grundinstallation bitte unbedingt einschalten und in der VM die Tools installiern!

Ansonsten besitzt die VM keine gültigen Hardwaretreiber und mithin KEINE Netzwerkkarte!

2. VM Betrieb

Die VMs können nun wie gewohnt in VMware oder Hyper-V verwaltet werden incl. Snapshot, Cloning etc. Uns intessiert aber am meisten ob die VM auch funktioniert. Wir überprüfen das in dem wir remote auf die VM zugreifen mit einen 2ten PC über das LAN:

Funkioniert! Wir sehen hier auch unter Software die Nutanix NGT Tools sowie unter SYSTEM KVM als Hypervisor!

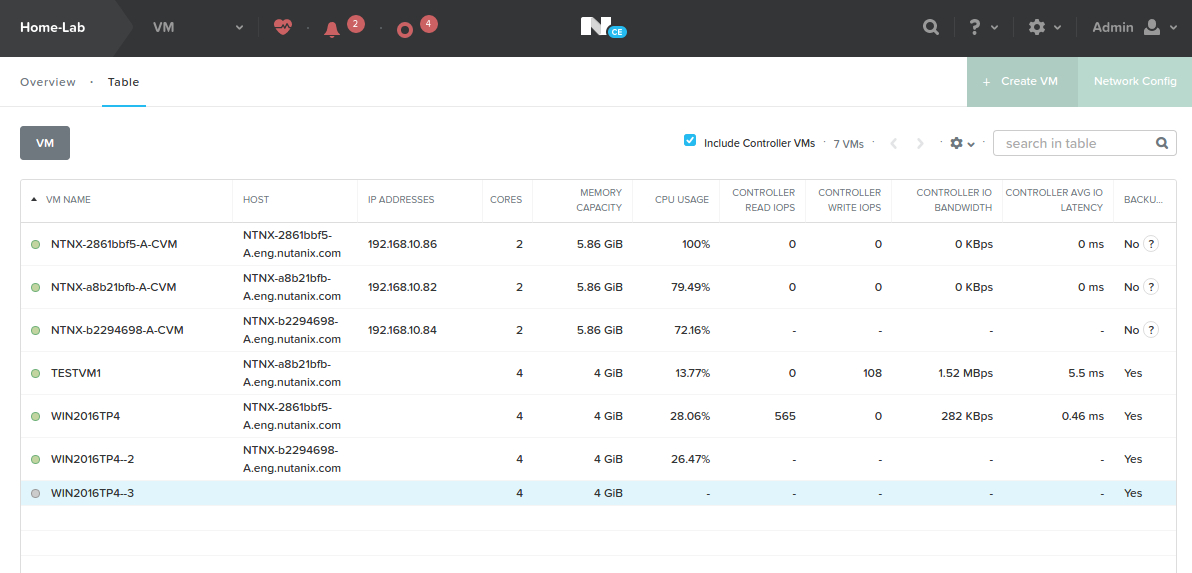

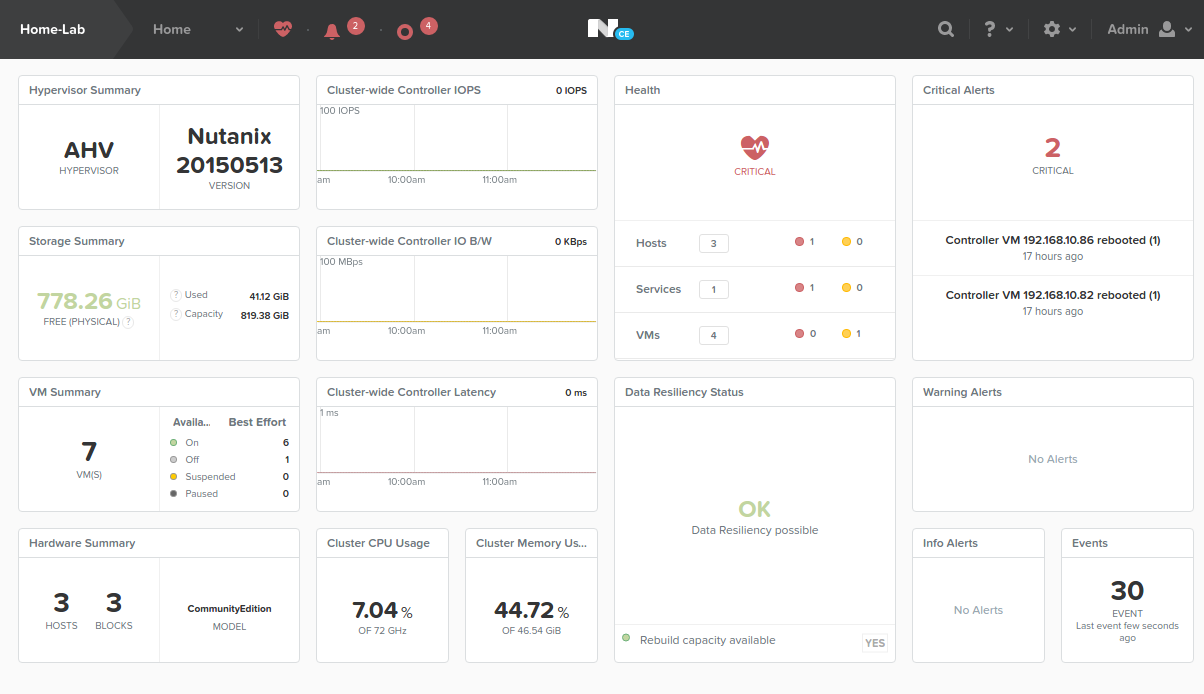

Jetzt kommt Leben in den Test und mehrere VMs laufen:

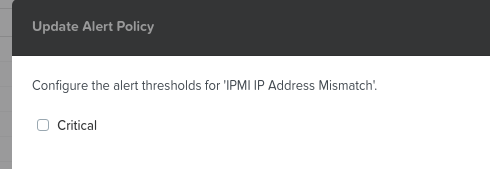

Da wir kein IPMI oder ILO etc. Board in der VMare haben schalten wir nun noch die ALERTS für IPMI unter ALERT Policies ab

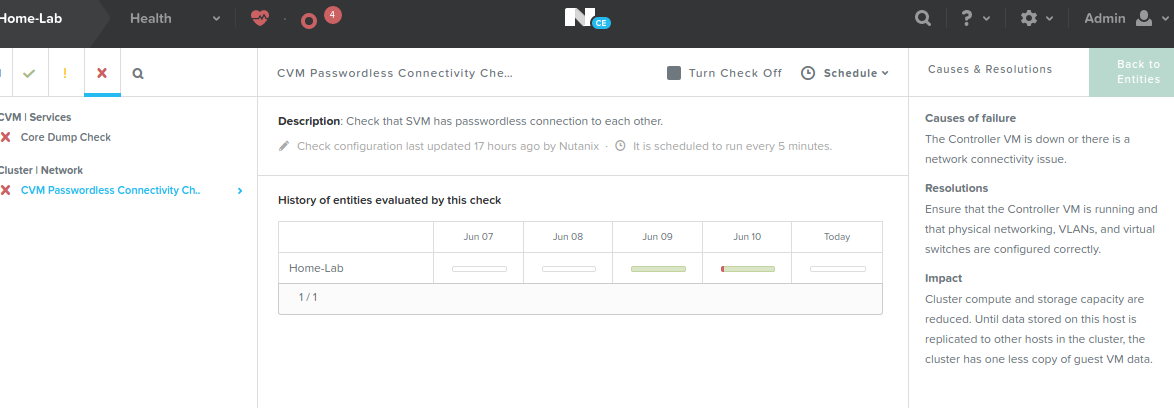

Es hilft nun auch unter HEALTH die CRITICAL Alerts anzusehen und evtl. abzuschalten:

Viel Spass beim Experementieren insbesondere beim Rebooten oder Abschalten einer CVM…

Der Host, welcher die HomeLab Umgebung hostet hat nun auch ordentlich Beschäftigung.